oracle-mongodb sharding分片模式的集群数据库,日志治理缺失导致写入数据库报错MongoWriteConcernException的问题总结(上)

推荐 原创一、背景

常见的mongodb集群模式有以下三种:

- 主从复制(Master-Slave)模式

- 副本集(Replica Set)模式

- 分片(Sharding)模式

公司测试环境搭建的集群采用分片模式,有同事反馈说,程序写入数据库报错。

详细错误见下:

Caused by: com.mongodb.MongoWriteConcernException: waiting for replication timed out; Error details: { wtimeout: true } at sdrs03

提示写入数据失败,因为是分片模式,所以它的数据是需要写入到两个分片服务机器上。

也就是说,这个错误很可能是因为一个分片写入成功,另一个写入失败所导致。

连接某个节点,连接Mongodb,执行命令sh.status()查看集群状态。

最后发现是某个机器的磁盘空间已满所引起的,当时为了快速回复,就手动删除了大日志文件。

今天有空就梳理一下问题,为了便于理解,画了一个部署架构图。

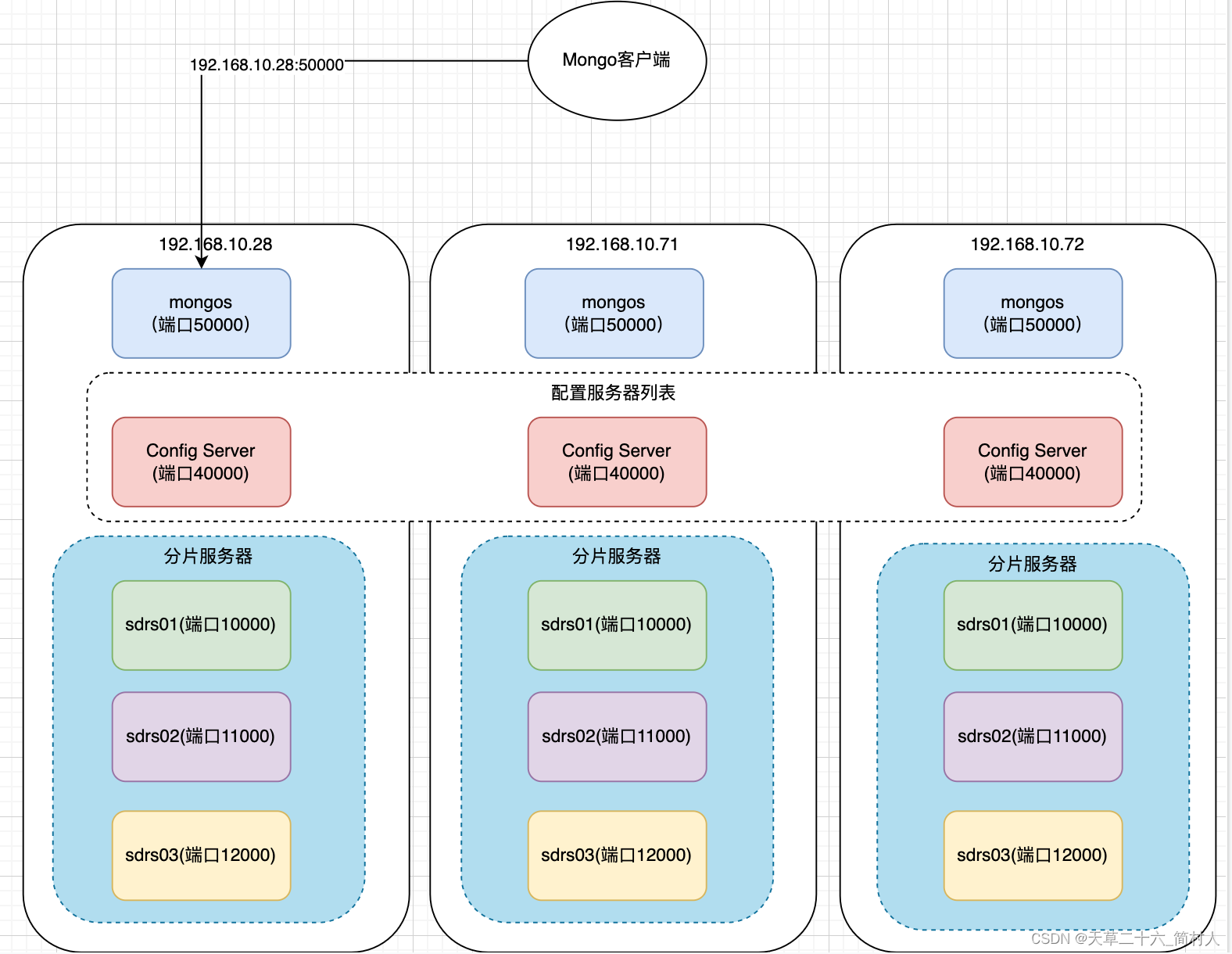

二、部署架构图

分片模式下,三个节点是等价关系,这里只举例其中一个来说。

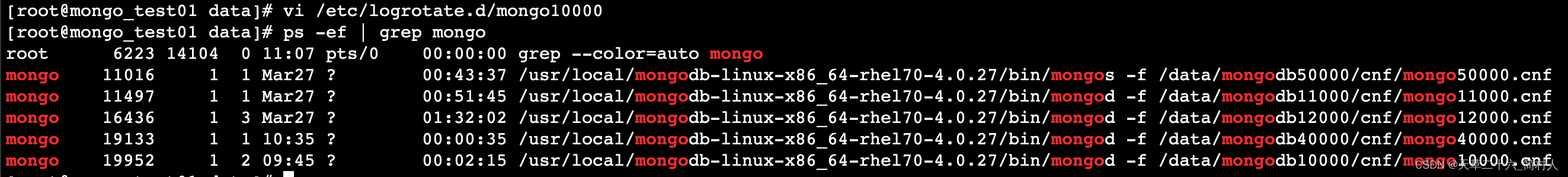

[root@mongo_test01 data]# ps -ef | grep mongo

root 6223 14104 0 11:07 pts/0 00:00:00 grep --color=auto mongo

mongo 11016 1 1 Mar27 ? 00:43:37 /usr/local/mongodb-linux-x86_64-rhel70-4.0.27/bin/mongos -f /data/mongodb50000/cnf/mongo50000.cnf

mongo 11497 1 1 Mar27 ? 00:51:45 /usr/local/mongodb-linux-x86_64-rhel70-4.0.27/bin/mongod -f /data/mongodb11000/cnf/mongo11000.cnf

mongo 16436 1 3 Mar27 ? 01:32:02 /usr/local/mongodb-linux-x86_64-rhel70-4.0.27/bin/mongod -f /data/mongodb12000/cnf/mongo12000.cnf

mongo 19133 1 1 10:35 ? 00:00:35 /usr/local/mongodb-linux-x86_64-rhel70-4.0.27/bin/mongod -f /data/mongodb40000/cnf/mongo40000.cnf

mongo 19952 1 2 09:45 ? 00:02:15 /usr/local/mongodb-linux-x86_64-rhel70-4.0.27/bin/mongod -f /data/mongodb10000/cnf/mongo10000.cnf

这里启动了五个进程,每个进程端口对应见上图。

- 分片服务器,对应端口10000/11000/12000

- 配置服务器,对应端口40000

- Mongos路由服务,对应端口50000,外部访问入口

三、详细配置

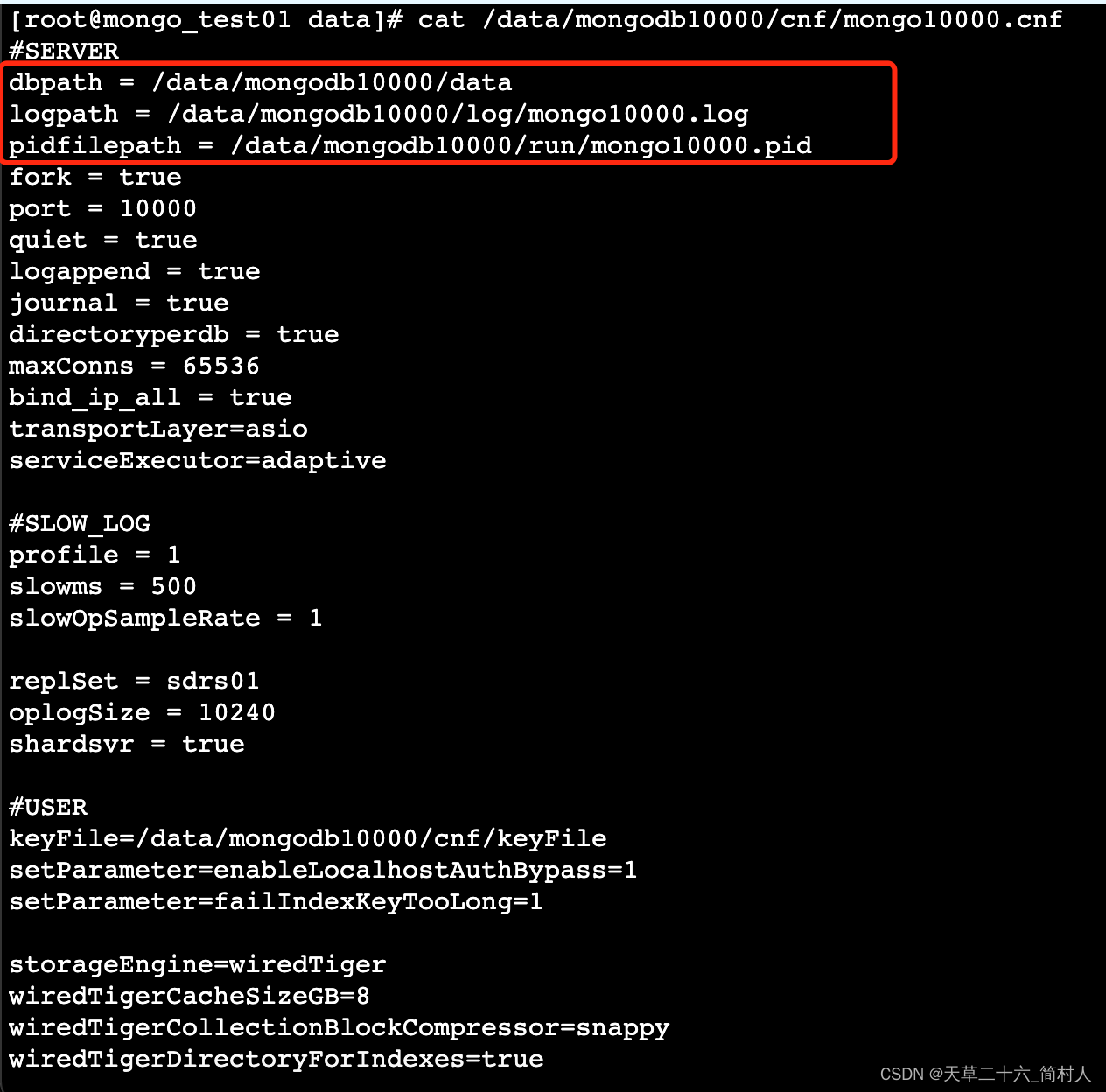

日志的保存路径和进程ID,见/data/mongodb{端口}/cnf/mongo{端口}.cnf

1、分片服务

因为三个分片配置类同,只是端口号不一样,所以仅以10000端口示例:

#SERVER

dbpath = /data/mongodb10000/data

logpath = /data/mongodb10000/log/mongo10000.log

pidfilepath = /data/mongodb10000/run/mongo10000.pid

fork = true

port = 10000

quiet = true

logappend = true

journal = true

directoryperdb = true

maxConns = 65536

bind_ip_all = true

transportLayer=asio

serviceExecutor=adaptive

#SLOW_LOG

profile = 1

slowms = 500

slowOpSampleRate = 1

replSet = sdrs01

oplogSize = 10240

shardsvr = true

#USER

keyFile=/data/mongodb10000/cnf/keyFile

setParameter=enableLocalhostAuthBypass=1

setParameter=failIndexKeyTooLong=1

storageEngine=wiredTiger

wiredTigerCacheSizeGB=8

wiredTigerCollectionBlockCompressor=snappy

wiredTigerDirectoryForIndexes=true

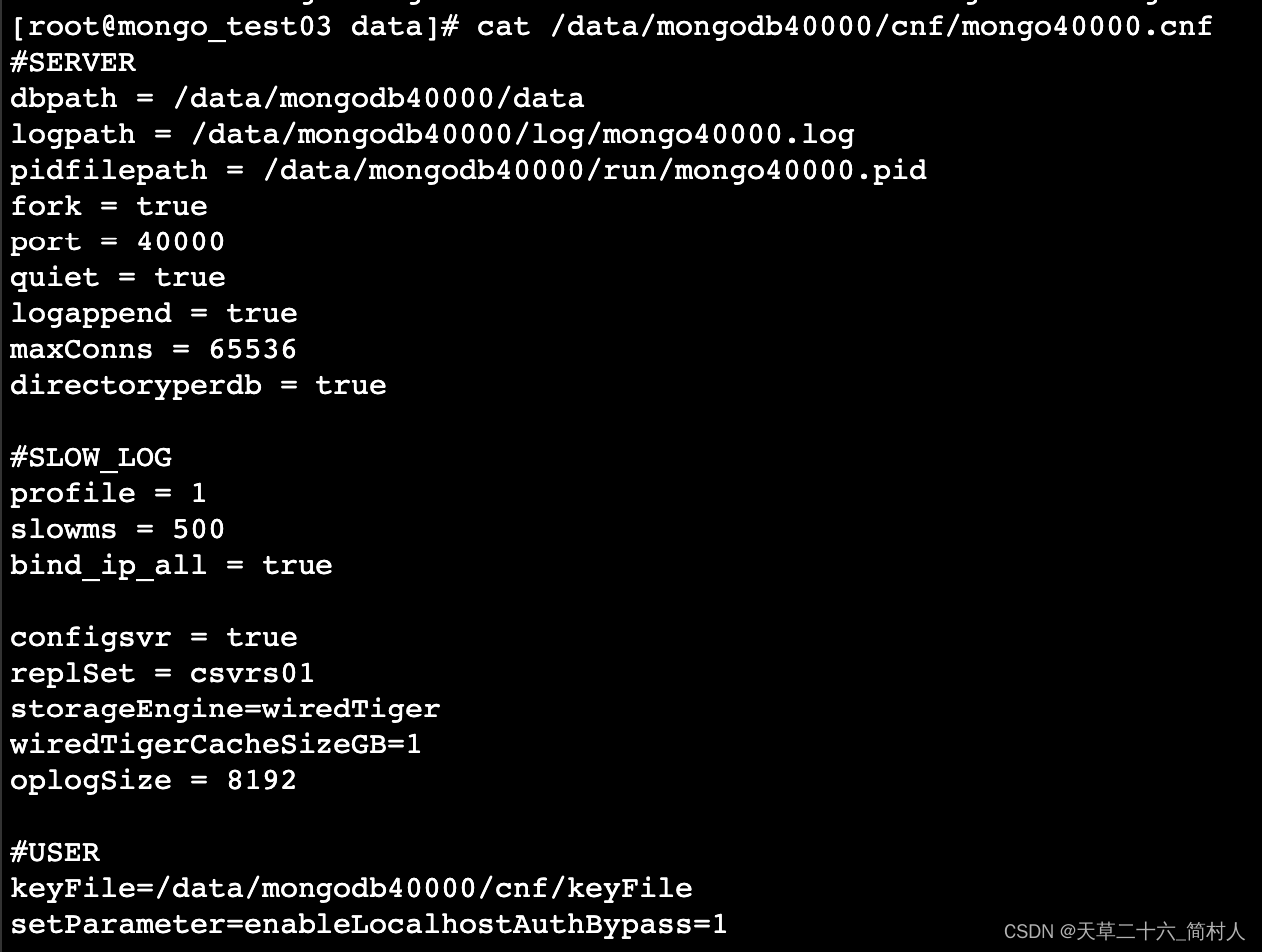

2、配置服务

复制集的名称是csvrs01,端口为40000,在后面的mongos会用到。

# cat /data/mongodb40000/cnf/mongo40000.cnf

#SERVER

dbpath = /data/mongodb40000/data

logpath = /data/mongodb40000/log/mongo40000.log

pidfilepath = /data/mongodb40000/run/mongo40000.pid

fork = true

port = 40000

quiet = true

logappend = true

maxConns = 65536

directoryperdb = true

#SLOW_LOG

profile = 1

slowms = 500

bind_ip_all = true

configsvr = true

replSet = csvrs01

storageEngine=wiredTiger

wiredTigerCacheSizeGB=1

oplogSize = 8192

#USER

keyFile=/data/mongodb40000/cnf/keyFile

setParameter=enableLocalhostAuthBypass=1

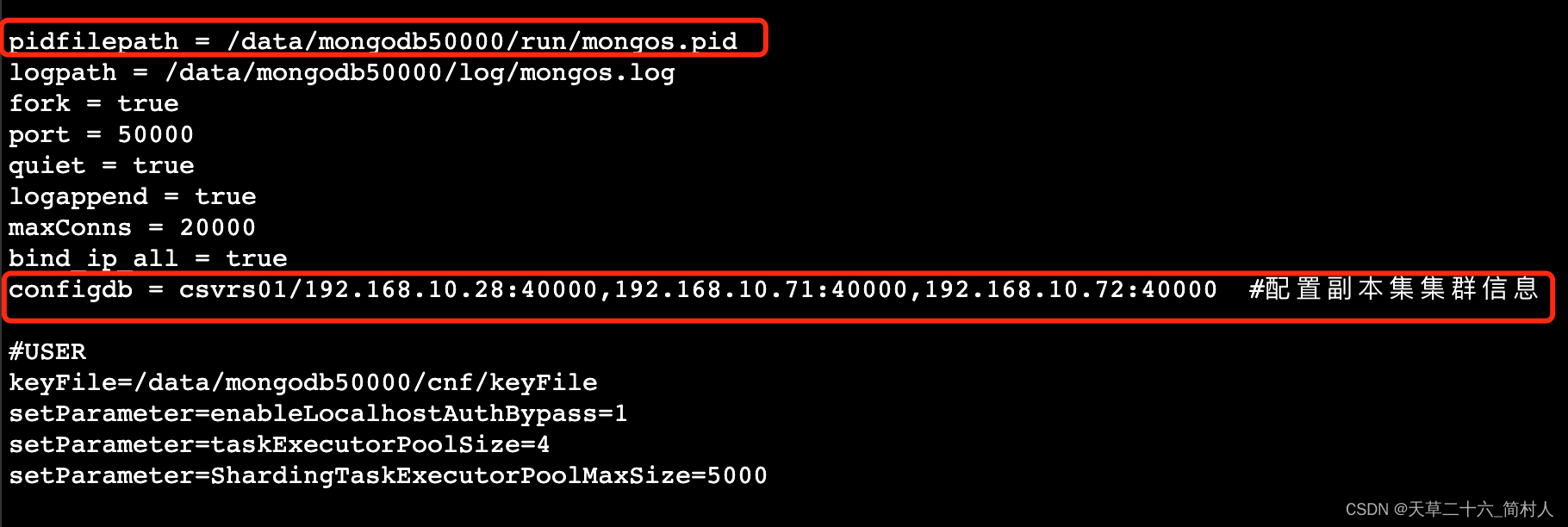

3、Mongos

这里填写了配置服务列表。另外需要注意一点,它的pid进程号是保存在/data/mongodb50000/run/mongos.pid,而非/data/mongodb50000/run/mongodb50000.pid。

pidfilepath = /data/mongodb50000/run/mongos.pid

logpath = /data/mongodb50000/log/mongos.log

fork = true

port = 50000

quiet = true

logappend = true

maxConns = 20000

bind_ip_all = true

configdb = csvrs01/192.168.10.28:40000,192.168.10.71:40000,192.168.10.72:40000

#USER

keyFile=/data/mongodb50000/cnf/keyFile

setParameter=enableLocalhostAuthBypass=1

setParameter=taskExecutorPoolSize=4

setParameter=ShardingTaskExecutorPoolMaxSize=5000

4、初始化副本集

在任意一台机器上使用 mongo 命令行工具连接到任意配置服务器,并初始化副本集sdrs01。

mongo --host 192.168.10.28:40000

use admin

cfg = {

_id: "sdrs01",

members: [

{ _id: 0, host: "192.168.10.71:10000" },

{ _id: 1, host: "192.168.10.72:10000" }

]

}

rs.initiate(cfg)

以此类推,初始化副本集sdrs02和sdrs03。

mongo --host 192.168.10.28:40000

use admin

cfg = {

_id: "sdrs02",

members: [

{ _id: 0, host: "192.168.10.28:11000" },

{ _id: 1, host: "192.168.10.71:11000" }

]

}

rs.initiate(cfg)

mongo --host 192.168.10.28:40000

use admin

cfg = {

_id: "sdrs03",

members: [

{ _id: 0, host: "192.168.10.28:12000" },

{ _id: 1, host: "192.168.10.72:12000" }

]

}

rs.initiate(cfg)

5、添加分片到路由服务器mongos

使用 mongo 命令行工具连接到路由服务器,并添加分片。

mongo --host 192.168.10.28:50000

use admin

sh.addShard("sdrs01/192.168.10.71:10000")

sh.addShard("sdrs01/192.168.10.72:10000")

sh.addShard("sdrs02/192.168.10.28:11000")

sh.addShard("sdrs02/192.168.10.71:11000")

sh.addShard("sdrs03/192.168.10.28:12000")

sh.addShard("sdrs03/192.168.10.72:12000")

注意,这里每个分片,只选择其中的两个节点作为副本。

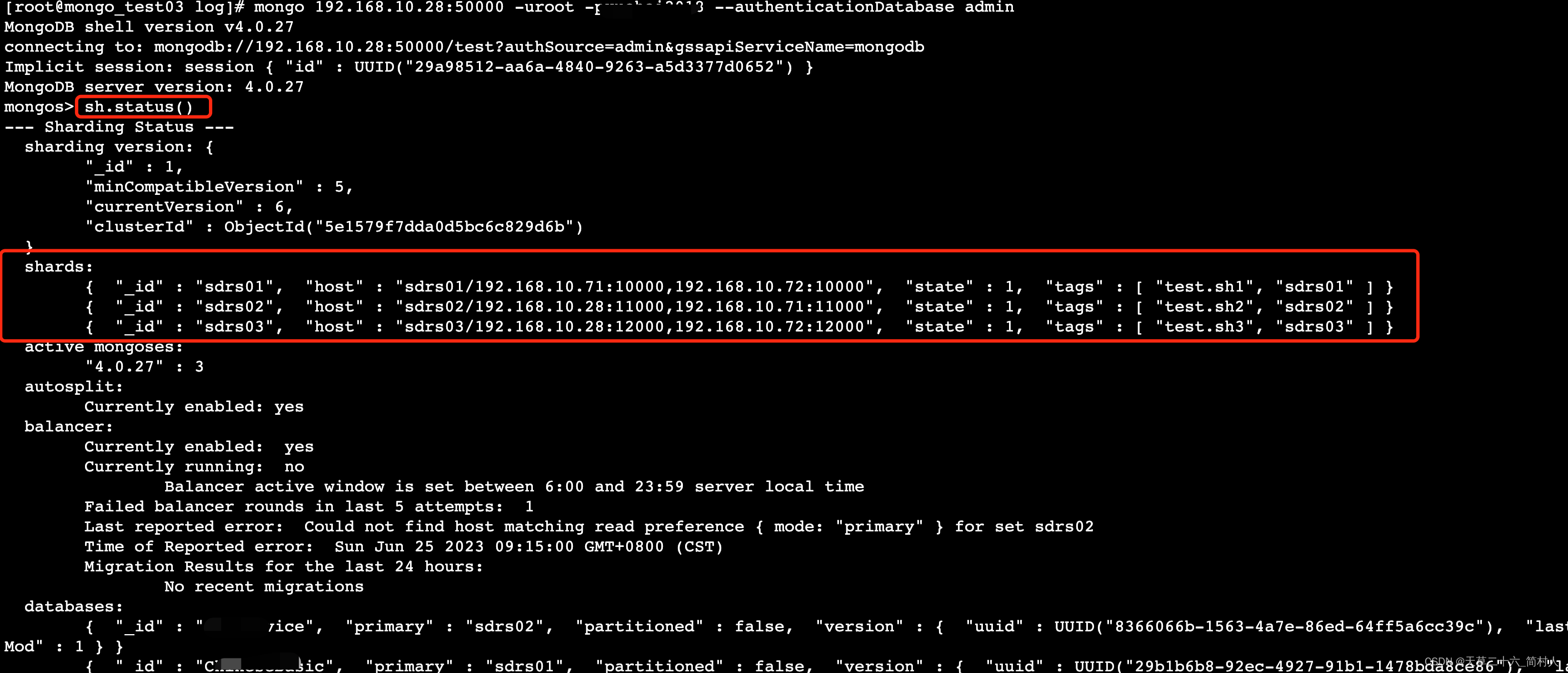

6、登录Mongos,查看集群状态

mongo 192.168.10.28:50000 -uroot -p{密码} --authenticationDatabase admin

> sh.status()

shards:

{ "_id" : "sdrs01", "host" : "sdrs01/192.168.10.71:10000,192.168.10.72:10000", "state" : 1, "tags" : [ "test.sh1", "sdrs01" ] }

{ "_id" : "sdrs02", "host" : "sdrs02/192.168.10.28:11000,192.168.10.71:11000", "state" : 1, "tags" : [ "test.sh2", "sdrs02" ] }

{ "_id" : "sdrs03", "host" : "sdrs03/192.168.10.28:12000,192.168.10.72:12000", "state" : 1, "tags" : [ "test.sh3", "sdrs03" ] }

四、未完待续

由于整篇文章比较冗长,我先介绍Mongodb sharding分片集群的搭建及配置详情,顺便梳理了其部署架构, 下文我将介绍其日志治理问题。

更多【oracle-mongodb sharding分片模式的集群数据库,日志治理缺失导致写入数据库报错MongoWriteConcernException的问题总结(上)】相关视频教程:www.yxfzedu.com

相关文章推荐

- 爬虫-网络爬虫的实战项目:使用JavaScript和Axios爬取Reddit视频并进行数据分析 - 其他

- c语言-ZZ038 物联网应用与服务赛题第C套 - 其他

- c语言-cordova Xcode打包ios以及发布流程(ionic3适用) - 其他

- 物联网-Xcode15 framework ‘CoreAudioTypes‘ not found - 其他

- 科技-打造高效运营底座,极智嘉一体化软件系统彰显科技威能 - 其他

- golang-深入剖析Golang中单例模式 - 其他

- 网络-工业自动化工厂PLC远程控制网关物联网应用 - 其他

- react.js-React Native自学笔记 - 其他

- android-【Android】Lombok for Android Studio 离线插件 - 其他

- android-Android Studio新建项目下载依赖慢,只需一个操作解决 - 其他

- 后端-使用 Ruby 的 Nokogiri 库来解析 - 其他

- 编程技术-一、配置环境 - 其他

- 算法-03 矩阵与线性变换 - 其他

- android-Android Studio(控件常用属性) - 其他

- 编程技术-ES使用ik分词器查看分词结果及自定义词汇 - 其他

- asp.net-asp.net水资源检测系统VS开发sqlserver数据库web结构c#编程Microsoft Visual Studio - 其他

- 编程技术-jQuery中遍历元素each - 其他

- 编程技术-rabbitmq下载安装教程 - 其他

- 编程技术-Codeforces Round 908 - 其他

- 编程技术-Leetcode543. 二叉树的直径 - 其他

2):严禁色情、血腥、暴力

3):严禁发布任何形式的广告贴

4):严禁发表关于中国的政治类话题

5):严格遵守中国互联网法律法规

6):有侵权,疑问可发邮件至service@yxfzedu.com