算法-(done) 什么是特征值和特征向量?如何求特征值的特征向量 ?如何判断一个矩阵能否相似对角化?

推荐 原创什么是齐次方程? https://blog.csdn.net/shimly123456/article/details/136198159

行列式和是否有解的关系? https://blog.csdn.net/shimly123456/article/details/136198215

特征值和特征向量 参考视频:https://www.bilibili.com/video/BV1vY4y1J7gd/?spm_id_from=333.337.search-card.all.click&vd_source=7a1a0bc74158c6993c7355c5490fc600

一个求特征值和特征向量 (手算,还包括矩阵相似对角化) 的例子:https://www.bilibili.com/video/BV14T4y127jf/?spm_id_from=333.337.search-card.all.click&vd_source=7a1a0bc74158c6993c7355c5490fc600

一个更详细的求特征值和特征向量(手算,提到了“自由未知量”)例子:https://www.bilibili.com/video/BV1Js4y1372V/?spm_id_from=333.337.search-card.all.click&vd_source=7a1a0bc74158c6993c7355c5490fc600

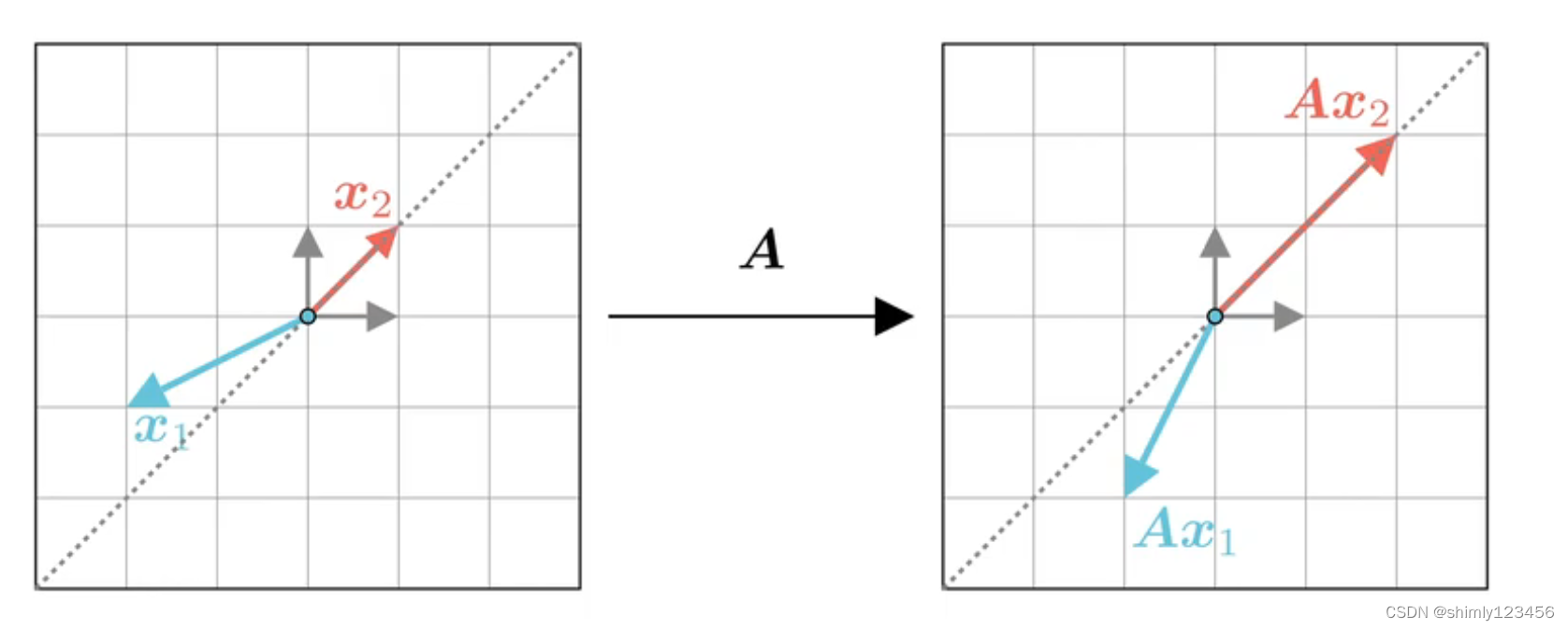

把矩阵 A 作为一个对向量的映射,x1 矢量在经过 A 映射后变换了方向,x2 经过 A 映射后保持原来的方式,只是长度发生了变化 (长度变换可以是负数,也就是 x2 方向变相反了也不影响)。像 x1 这种向量就不是 矩阵A 的特征向量;x2 这种向量就是矩阵 A 的特征向量

由于 矩阵A 对特征向量 x2 只起到了伸缩作用,那么就可以写下式子 (lamda 是一个常数、标量)

Ax2 = (lamda) * x2

在这里,(lamda) 就是特征值,x2 就是特征向量

所以,特征向量的严格定义就是:只要一个向量 x2 可以写成 Ax2 = (lamda) * x2。那么 lamda 就是矩阵 A 的特征值,x2 就是矩阵 A 的特征向量

一个矩阵可以有多个特征值和特征向量,如下图为例:

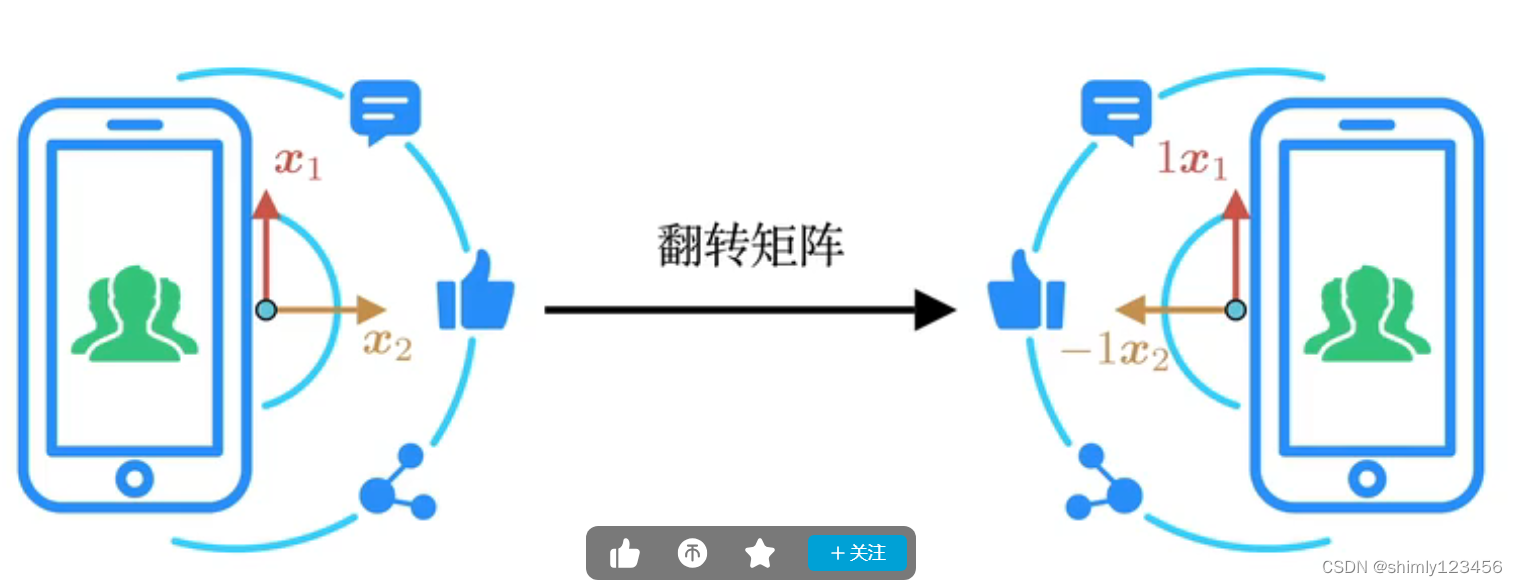

图片可以经过线性变化(或者说,矩阵乘法)进行翻转,只要把图片上的每一个像素点视为一个矢量,然后让它们乘以翻转矩阵即可。

在这里,经过翻转矩阵映射后,图片左右翻转了,每一个像素点(即,矢量) 在纵轴上的方向没有变化,所以有纵特征向量 x1,在横轴上的方向变反了,所以有横特征向量 x2。x1 和 x2 的特征值分别是 1 和 -1

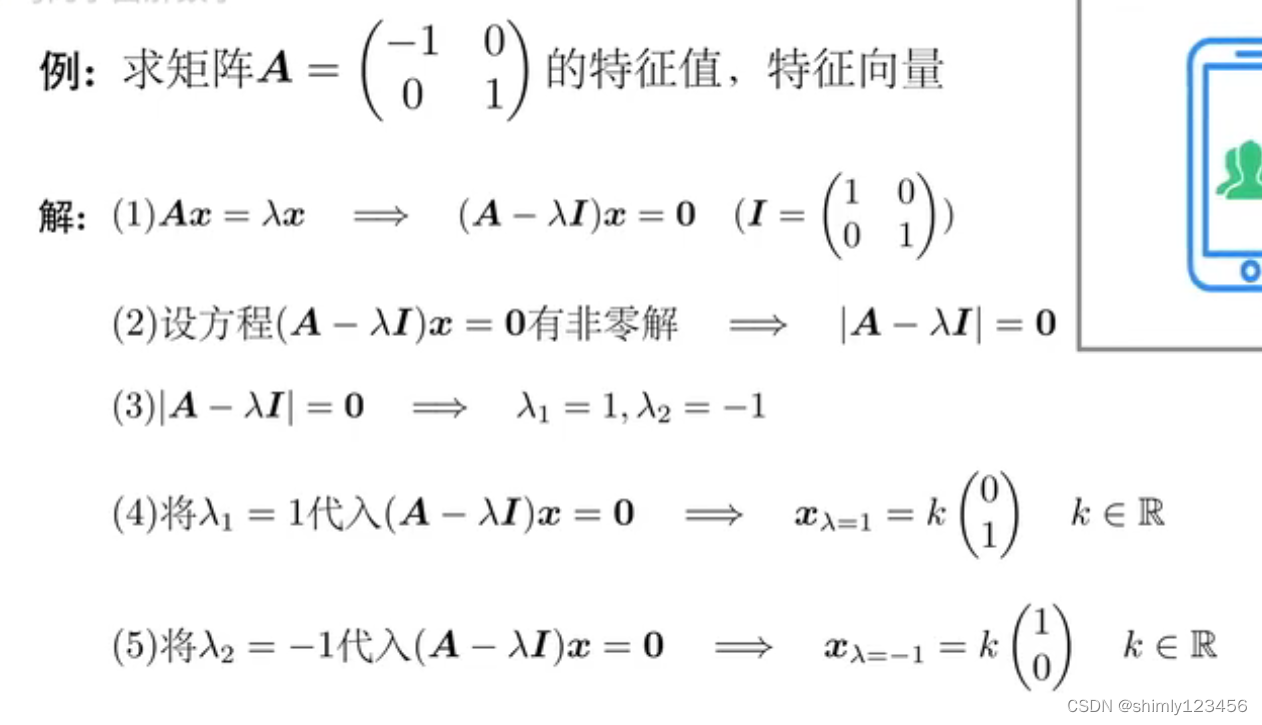

接下来,我们看看特征值和特征向量的严格数学计算

如果看不懂,可以再看一遍参考视频,也就 6min,不长

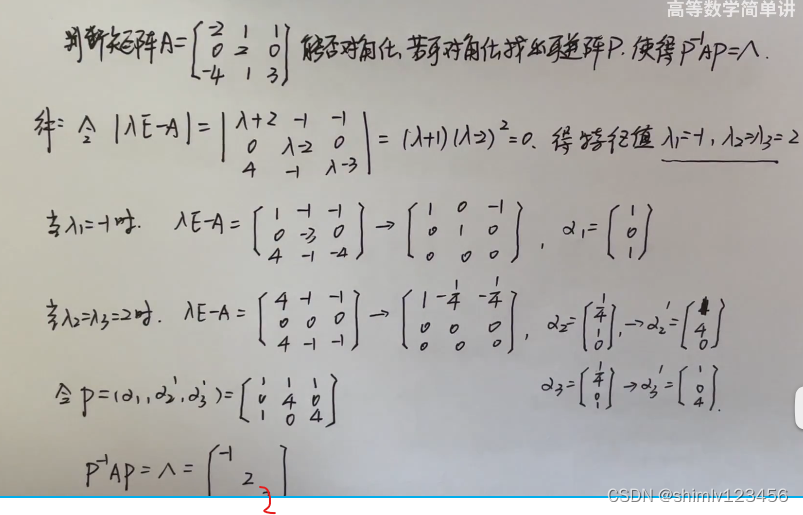

以下是一个求特征值、特征向量,从而把矩阵相似对角化的例子:

当 lamda1 = lamda2 = 2 时,我们发现求出的矩阵只有一个非零行,那么也就是说它的 “自由未知量” 是 2。

这其实暗含了 “我们能够得到两个线性无关非零解” 的意思,也就说这个矩阵是可以相似对角化的

更多【算法-(done) 什么是特征值和特征向量?如何求特征值的特征向量 ?如何判断一个矩阵能否相似对角化?】相关视频教程:www.yxfzedu.com

相关文章推荐

- c#-C#中Linq AsEnumeralbe、DefaultEmpty和Empty的使用 - 其他

- jvm-JVM关键指标监控(调优) - 其他

- 编程技术-JavaScript + setInterval实现简易数据轮播效果 - 其他

- 编程技术-Datawhale智能汽车AI挑战赛 - 其他

- 编程技术-针对CSP-J/S的每日一练:Day 6 - 其他

- 编程技术-【vue实战项目】通用管理系统:api封装、404页 - 其他

- 云计算-软考 系统架构设计师系列知识点之云计算(3) - 其他

- 编程技术-排查Windows内存泄漏问题的详细记录 - 其他

- pdf-ReportLab创建合同PDF - 其他

- 编程技术-应用协议安全:Rsync-common 未授权访问. - 其他

- 编程技术-十九章总结 - 其他

- 编程技术-实用干货丨Eolink Apikit 配置和告警规则的各种用法 - 其他

- 系统架构-垂直领域对话系统架构 - 其他

- python-pycharm pro v2023.2.4(Python编辑开发) - 其他

- 云原生-修炼k8s+flink+hdfs+dlink(七:flinkcdc) - 其他

- 算法-《深入浅出进阶篇》洛谷P4147 玉蟾宫——悬线法dp - 其他

- 接口隔离原则-ISP图像处理Pipeline - 其他

- 编程技术-WPF中Dispatcher对象的用途是什么 - 其他

- 学习-ARM & Linux 基础学习 / Ubuntu 下的包管理 / apt工具 - 其他

- 编程技术-【ROS】RViz2源码分析(一):介绍 - 其他

2):严禁色情、血腥、暴力

3):严禁发布任何形式的广告贴

4):严禁发表关于中国的政治类话题

5):严格遵守中国互联网法律法规

6):有侵权,疑问可发邮件至service@yxfzedu.com

- jvm-【面经】讲一下你对jvm和jmm的了解

- rabbitmq-RabbitMQ的高级特性

- 数据库-长安链可验证数据库,保证数据完整性的可信存证方案

- 前端框架-React Hooks为什么要在顶层使用?

- flink-Flink之Java Table API的使用

- c#-C# List<T>.IndexOf()方法的使用

- 计算机视觉-Libra R-CNN: Towards Balanced Learning for Object Detection(2019.4)

- ar-Angular 由一个bug说起之一:List / Grid的性能问题

- vr-VR全景技术,为养老院宣传推广带来全新变革

- 网络-【广州华锐互动】VR安防网络综合布线仿真实训打造沉浸式的教学体验