量子计算-微软称在量子纠错领域取得大进展,量子超级计算机能在2033年问世?

推荐 原创

大数据产业创新服务媒体

——聚焦数据 · 改变商业

自从物理学家费曼(Richard Feynman)在80年代首次提出了利用量子力学原理进行计算的概念,无数科学家就梦想着用量子计算重塑未来。可惜现实往往“磕磕绊绊”,40多年过去了,量子计算依然囿于实验室,难以真正落地应用。

然而,这一现状迎来了转机。周三,微软在官网发布了一系列博客文章和论文,宣布在量子纠错领域获得突破性进展,大幅推动了量子计算机的落地进度:

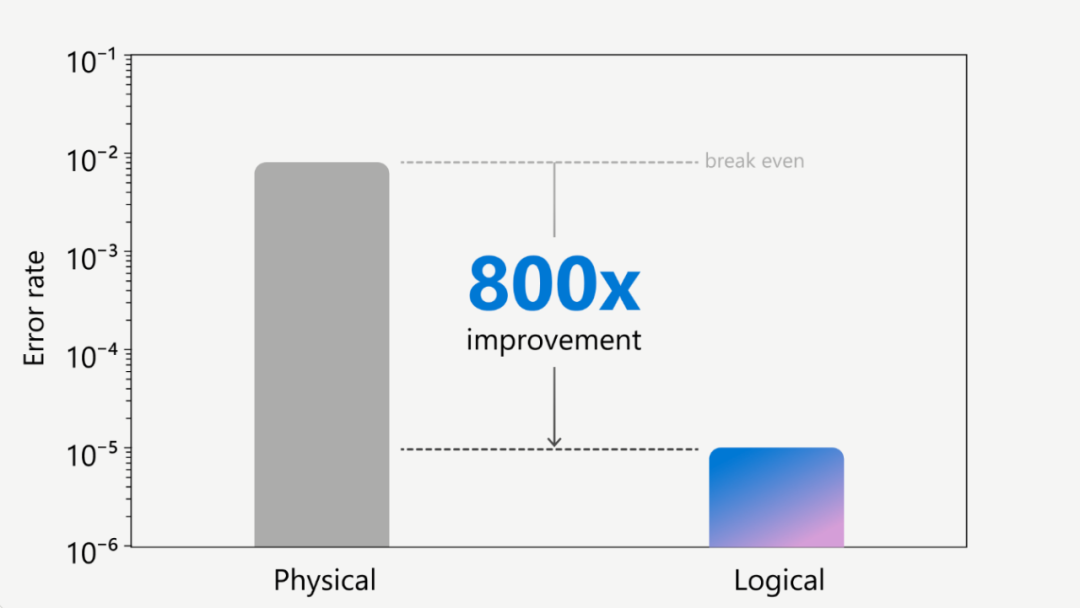

通过将微软的量子比特虚拟系统(qubit-virtualization system),错误诊断和改正手段(error diagnostics and correction),与Quantinuum公司的离子阱硬件(trapped-ion hardware)相结合,迄今为止最可靠的逻辑量子比特被创造出来。相较于单个物理量子比特,这种逻辑量子比特的错误率改善了800倍。

Credit: Microsoft

具体来说,仅利用30个物理量子比特,微软成功构建了4个高度可靠的逻辑量子比特。在14000次试验中,这4个逻辑量子比特运行始终平稳如初,未现任何错误。

这一突破之所以备受关注,是因为长期以来,管理和纠正量子误差一直是阻碍量子计算机真正落地的最大障碍。量子系统由于易受噪声和退相干现象的影响,极易导致量子态失常、计算出现错误。此外,不精确的量子门操作和测量过程也可能引入误差,使之逐步累积,影响最终结果的准确性。

因此,即便拥有再多量子比特,量子计算机也难以完全发挥其超强的并行处理能力,这就是为什么到目前为止,量子计算机仅用于研究和实验的主要原因。而微软和Quantinuum这一突破,正是为解决这一挑战迈出的关键一步。

那么微软是怎么做到的呢?

在量子计算机中,基本单位被称为“量子比特(quantum bit)”或“量子位(qubit)”。与传统计算机中只能代表0或1的最小数据单位“bit”不同,量子比特可以同时处于0和1的叠加态,让每个量子比特同时执行两个计算。

这是量子计算机拥有超越传统计算机的计算能力的关键所在:量子计算机中通过量子力学连接的量子比特越多,其计算能力就可以以指数方式增长。

量子计算机大约每千次操作就会出现一个错误,通常有两种方式来降低错误率:

1、提高单个物理量子比特及其上执行的操作的质量,其中包括最大限度地减少温度波动或电磁干扰等因素造成的外部噪音;利用不易退相干的先进材料;开发更精确的量子门操作等。

2、使用逻辑量子比特进行纠错,将多个物理量子比特组合成更可靠的虚拟量子比特。

此次突破主要通过第2种途径实现。微软仅使用30个物理量子比特就构建出了4个高度可靠的逻辑量子比特。相较于先前的研究,这种量子纠错策略所需的物理量子比特数量预期至少为1000个,因此这是一个巨大的飞跃。

“主动症状提取(Active Syndrome Extraction)”,一种微软新开发的,能够在不破坏逻辑量子比特的情况下进行诊断和纠正错误的方法,也在这次突破中发挥了重要作用。

测量量子态(如叠加态)的行为通常会破坏它。为了避免这种情况,“主动症状提取”并不关注量子比特的量子态,而是学习与噪声相关的量子比特细节。具备考虑噪声的能力可以让更长更复杂的量子计算顺利进行,而不会出现故障,同时也不会破坏逻辑量子比特。微软称它在2个逻辑量子比特上运行了多轮的“主动症状提取”。

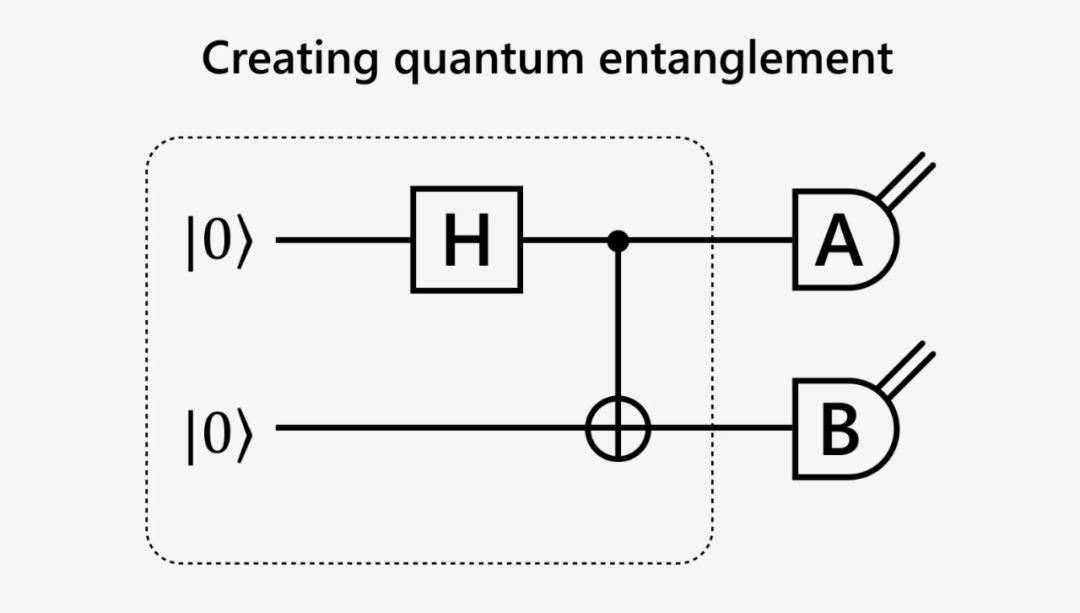

微软展示了如何进行纠缠量子比特的准备工作(如下图)。 虚线内的部分是用于创建纠缠态的电路的粗略表示。A 和 B 代表可应用于状态每一半的测量值。 在没有错误的情况下,如果应用于每一半的测量类型相同,则一半的结果应与另一半的结果一致。

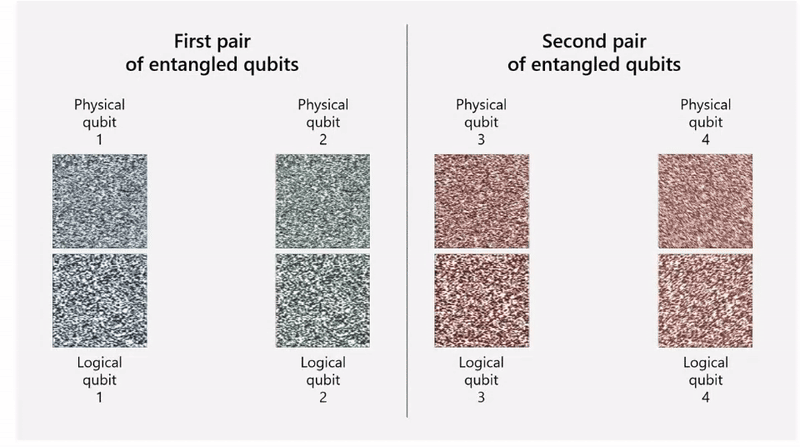

下图展示了纠缠的量子比特之间的差异(误差):通过比较一对量子比特中每个量子比特的图像可以发现差异,存在的任何差异都会以点的形式出现在每对量子比特的之间的图块上。物理量子比特对之间存在错误,第一排中间图块中的“小点”就证明了这一点。 相比之下,纠缠的逻辑量子比特之间不存在任何错误,从第二排中间的不存在“小点”的空白图块中可以看出。

Credit: Microsoft

微软迈入量子计算机发展的韧性阶段

微软报告称,最新的突破标志着其在量子计算机的第2个发展阶段中获得了先机,并计划在不久的将来在 Azure Quantum Elements 的私人预览版中提供这些功能。

我们先来回顾一下,7个月前微软战略任务和技术部门执行副总裁Jason Zander在LinkedIn上关于量子计算机发展的3个阶段的介绍:

第 1 级(Foundational-基础):这个阶段厂商都专注于增加和宣传一个虚荣的指标,即量子比特的数量,而忽略了保真度。保真度达到99%的NISQ系统只能用于量子计算研发,无助于解决现实问题。

第 2 级(Resilient-韧性):需要约 200 个以上的逻辑量子比特来进行一些基本的科学工作,这涉及使用逻辑量子比特来实施纠错技术。目前(即截至2023年8月)还没有供应商达到这个水平。

第 3 级(Scale-规模):要解决最困难的科学问题,必须拥有至少一百万次可靠的每秒量子运算 (rQOPS),且逻辑错误率只有万亿分之一。这涉及扩展逻辑量子比特,以创建真正的量子超级计算机,能够以高可靠性执行复杂的算法。

每个级别的成功标准都是通过逻辑量子比特错误率、逻辑量子比特数量和可扩展性等因素来衡量的。

在周三发布的通稿中,这位副总裁表示,“这使我们摆脱了当前嘈杂的中尺度量子 (NISQ) 级别,进入到了2 级韧性量子计算阶段。”根据他之前在LinkedIn上的长文,真正地实现2级,需要约 200 个以上的逻辑量子比特,这表明微软还需要在实现更大规模的逻辑量子比特上继续投入。

自 2019 年以来,微软一直与 Quantinuum 合作,使量子开发人员能够在离子阱量子比特技术上编写和运行自己的量子代码,其中包括高保真、完全连接和中电路测量。

此次实验中,微软使用的是Quantinuum新一代的量子计算机H2,它采用独特的“跑道”设计使32 个量子比特实现全连接,这意味着 H2 中的每个量子比特都可以直接与系统中的任何其他量子比特成对纠缠。

Quantinuum 是全球最大的综合量子计算公司,由 Cambridge Quantum 和 Honeywell Quantum Solutions 合并而成,专注于开发基于俘获离子技术的量子计算系统。最近,该公司与谷歌旗下的 DeepMind 合作开展了一个项目,利用人工智能解决量子计算中的棘手问题。

除了与 Quantinuum 的合作之外,微软在量子领域还进行了颇多布局。例如,它直接投资了专注于为量子计算提供光子技术的公司 Photonic Inc. ,并与之建立了合作伙伴关系;此外,它还成为了致力于利用硅光子量子比特打造首台通用量子计算机的 PsiQuantum 的重要投资者。

量子超级计算机会在10年内诞生?

凭借量子力学原理,量子计算机可在密码学、材料科学、药物研发等领域实现指数级的运算加速,大幅提升人类的信息处理能力,甚至重塑未来社会的信息基础设施。因此,量子计算被视为最具有颠覆性的技术之一,将引领人类社会进入全新的信息时代,科技巨头们都在加大在该领域的投入力度。

作为量子计算研究领域的领导者之一,谷歌专注于构建自己的量子硬件。开发了一种超导量子比特设计,并持续努力提高其相干时间和可扩展性,以构建更大规模的量子计算机。

在软件和云集成方面,谷歌拥有得天独厚的优势和积累。它不仅开发了TensorFlow Quantum等工具,用于设计和运行量子机器学习模型,还在自己的云平台上提供基于Sycamore 处理器的量子虚拟机服务。

坐拥全球市场份额第一的云服务AWS的亚马逊则更集中精力在基于云的量子计算资源方面:通过与其他量子硬件开发商合作,提供相关的云服务。

AWS还是量子计算领域开源软件与协作的坚定倡导者,与加州理工学院合作推出 AWS 量子计算中心,以加速该领域的研究与开发。此外,它还发布了 Amazon Braket 等开源软件工具,用于在各类硬件平台上设计与运行量子电路。

以硬件见长的IBM也在这场竞赛中全力以赴。不仅公布了计划在2033年推出“具有 1,000 个逻辑量子比特的以量子为中心的超级计算机”,还在官网上挂出了“未来的计算是以量子为核心”的口号。

与IBM不谋而合的是,微软在去年6月推出了“充满野心”的路线图,计划在10年内推出一台每秒可进行百万次可靠计算的量子超级计算机。

当时看来,无论对IBM还是微软而言,这都是一个难以企及的目标。但随着可靠量子计算的突破,量子比特虚拟化系统的不断改进,以及硬件能力的持续提升,这一目标或许并不遥远。

文:王茜茜 / 数据猿

责编:凝视深空 / 数据猿

更多【量子计算-微软称在量子纠错领域取得大进展,量子超级计算机能在2033年问世?】相关视频教程:www.yxfzedu.com

相关文章推荐

- 笔记-【动手学深度学习】课程笔记 05-07 线性代数、矩阵计算和自动求导 - 其他

- 安全-水利部加快推进小型水库除险加固,大坝安全监测是重点 - 其他

- 微服务-Java版分布式微服务云开发架构 Spring Cloud+Spring Boot+Mybatis 电子招标采购系统功能清单 - 其他

- 开发语言-怎么学编程效率高,编程练习网站编程软件下载,中文编程开发语言工具下载 - 其他

- 安全-iPortal如何灵活设置用户名及密码的安全规则 - 其他

- 集成测试-如何使用 Loadgen 来简化 HTTP API 请求的集成测试 - 其他

- yolo-基于YOLOv8与DeepSORT实现多目标跟踪——算法与源码解析 - 其他

- 编程技术-【机器学习】Kmeans聚类算法 - 其他

- 集成学习-【Python机器学习】零基础掌握RandomForestRegressor集成学习 - 其他

- java-LeetCode //C - 373. Find K Pairs with Smallest Sums - 其他

- 集成学习-【Python机器学习】零基础掌握StackingClassifier集成学习 - 其他

- 编程技术-如何提高企业竞争力?CRM管理系统告诉你 - 其他

- java-Java - Hutool 获取 HttpRequest:Header、Body、ParamMap 等利器 - 其他

- c++-C++特殊类与单例模式 - 其他

- 编辑器-vscode git提交 - 其他

- 前端-WebGL的技术难点分析 - 其他

- c++-【c++之设计模式】组合使用:抽象工厂模式与单例模式 - 其他

- python-【JavaSE】基础笔记 - 类和对象(下) - 其他

- github-Redis主从复制基础概念 - 其他

- 运维-【iOS免越狱】利用IOS自动化WebDriverAgent实现自动直播间自动输入 - 其他

2):严禁色情、血腥、暴力

3):严禁发布任何形式的广告贴

4):严禁发表关于中国的政治类话题

5):严格遵守中国互联网法律法规

6):有侵权,疑问可发邮件至service@yxfzedu.com

- spring-Spring Boot中处理简单的事务

- 网络-【hcie-cloud】【4】华为云Stack规划设计之华为云Stack标准组网【中】

- 华为云-基于STM32设计的智能水母投喂器(华为云IOT)

- 缓存-【Redis】list常用命令&内部编码&使用场景

- pdf-PDF有限制密码,不能复制怎么办?

- objective-c-【Objective-C】Objective-C汇总

- node.js-npm切换镜像源

- github-Jekyll框架编译GithubPages,提示没有docs

- node.js-npm 换源

- objective-c-C++模板元模板(异类词典与policy模板)- - - 题目答案